Bản cập nhật chip Graviton4 có thể đọc 100 đĩa CD nhạc/giây, Amazon tuyên chiến với Nvidia

Amazon Web Services chuẩn bị công bố bản cập nhật cho chip Graviton4, với băng thông mạng lên tới 600 gigabit mỗi giây, mức mà công ty gọi là cao nhất trong lĩnh vực điện toán đám mây công cộng.

Ali Saidi, kỹ sư lỗi lạc tại Amazon Web Services, ví tốc độ này như một cỗ máy có thể đọc được 100 đĩa CD nhạc mỗi giây.

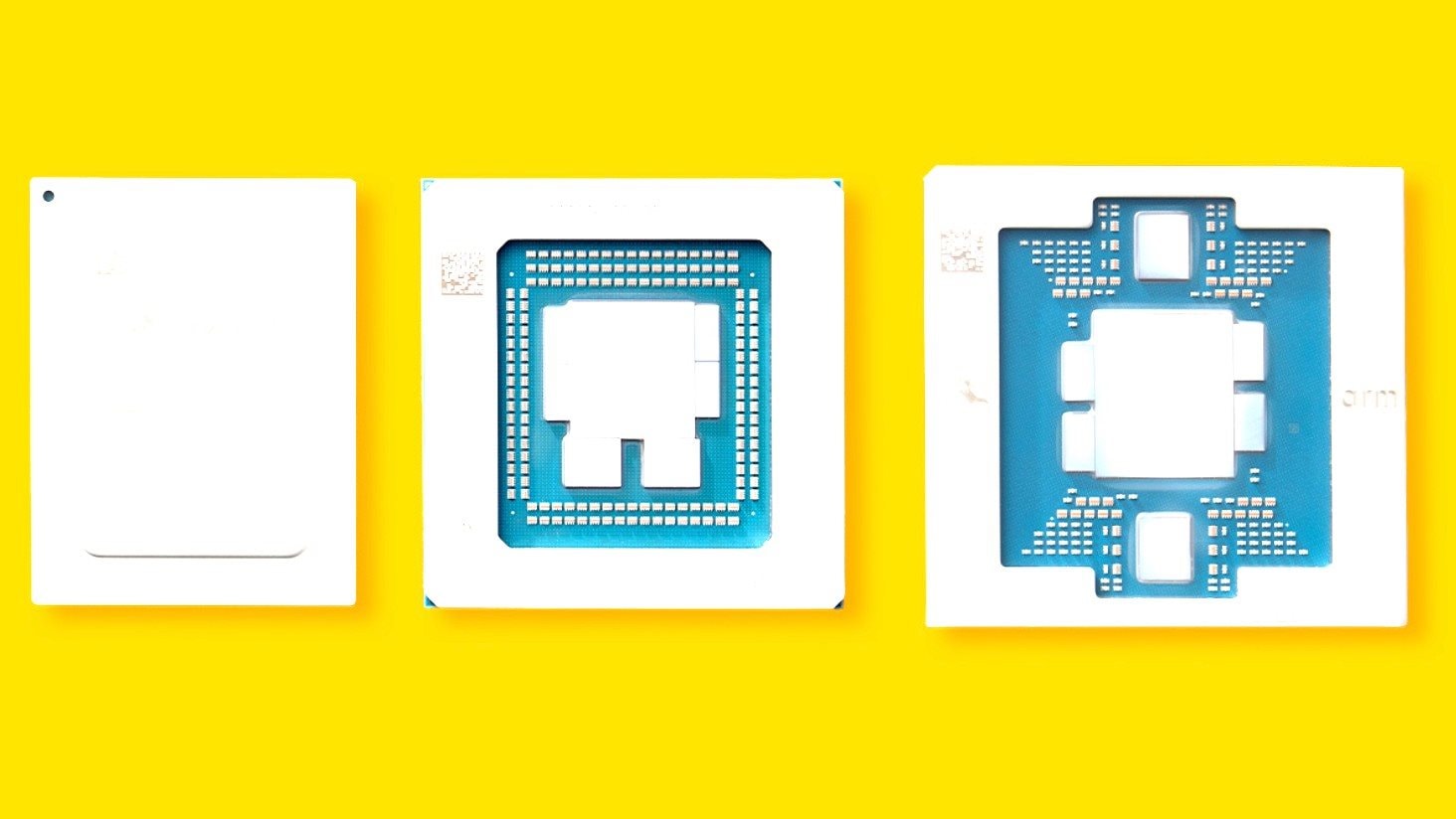

Graviton4 là bộ xử lý trung tâm (CPU), một trong nhiều sản phẩm chip đến từ Phòng thí nghiệm Annapurna của Amazon tại thành phố Austin, bang Texas, Mỹ. Graviton4 là một bước tiến trong chiến lược phát triển chip tùy chỉnh của Amazon, giúp gã khổng lồ thương mại điện tử cạnh tranh trực tiếp với các đối thủ bán dẫn truyền thống như Intel và AMD.

Tuy nhiên, trận chiến thực sự lại diễn ra với Nvidia trong thị trường cơ sở hạ tầng trí tuệ nhân tạo (AI).

Tại hội nghị re:Invent 2024 vào tháng 12.2024, Amazon Web Services đã công bố Project Rainier - siêu máy tính AI được xây dựng dành riêng cho công ty khởi nghiệp Anthropic. Amazon Web Services đã đầu tư 8 tỉ USD để hậu thuẫn Anthropic.

Ông Gadi Hutt, Giám đốc cấp cao phụ trách kỹ thuật sản phẩm và khách hàng tại Amazon Web Services, cho biết Amazon đang tìm cách giảm chi phí huấn luyện AI và cung cấp một lựa chọn thay thế cho các bộ xử lý đồ họa (GPU) đắt đỏ của Nvidia.

Theo Amazon Web Services, mô hình AI Claude Opus 4 của Anthropic đã được huấn luyện trên các GPU Trainium2, và Project Rainier được vận hành bởi hơn nửa triệu chip này - một đơn hàng trước đây lẽ ra sẽ thuộc về Nvidia.

Amazon: Có thể kết nối nhiều chip hơn Nvidia, giúp khách hàng tiết kiệm chi phí

Hồi tháng 12.2024, Amazon Web Services đã giới thiệu các máy chủ trung tâm dữ liệu mới chứa các chip AI do chính họ sản xuất, nhằm cạnh tranh với Nvidia.

Các máy chủ này, sử dụng 64 chip Trainium2 của Amazon Web Services, sẽ được kết nối thành một siêu máy tính khổng lồ với hàng trăm ngàn chip, có sự hợp tác của công ty khởi nghiệp AI Anthropic – khách hàng đầu tiên sử dụng. Benoit Dupin, Phó giám đốc cấp cao phụ trách học máy và AI tại Apple, xác nhận công ty này đang sử dụng các chip Trainium2.

Các máy chủ này, được Amazon Web Services gọi là Trn2 UltraServers, sẽ cạnh tranh với máy chủ hàng đầu của Nvidia chứa 72 chip AI Blackwell mới nhất. Cả hai công ty đều cung cấp công nghệ độc quyền để kết nối các chip, nhưng Gadi Hutt (người đứng đầu mảng phát triển kinh doanh chip AI tại Amazon Web Services) cho biết họ có thể kết nối nhiều chip hơn Nvidia.

“Chúng tôi tin rằng với Trainium2, khách hàng có thể đạt được hiệu suất tính toán cao hơn so với Nvidia hiện nay, và cũng có thể tiết kiệm chi phí”, Gadi Hutt chia sẻ với hãng tin Reuters, đồng thời nói một số mô hình AI có thể được đào tạo với chi phí thấp hơn 40% so với khi sử dụng chip Nvidia.

Nvidia hiện thống trị lĩnh vực chip AI, trong khi các đối thủ truyền thống, gồm cả AMD, đang nỗ lực chạy theo.

Tuy nhiên, một số đối thủ mạnh nhất với Nvidia cũng là khách hàng của họ gồm Meta Platforms, Microsoft và Google – cả ba đều có chip AI tùy chỉnh riêng. Trong khi chip Meta Platforms phục vụ cho các hoạt động nội bộ, Amazon và Google vừa sử dụng chip của mình cho mục đích nội bộ vừa cung cấp cho khách hàng trả phí.

Matt Garman, Giám đốc điều hành Amazon Web Services, cho biết thế hệ chip AI tiếp theo của công ty là Trainium3 sẽ ra mắt cuối năm 2025. Sản phẩm mới này “được thiết kế riêng cho các khối lượng công việc khắt khe về đào tạo và suy luận AI tạo sinh”, Matt Garman tiết lộ.

Amazon Web Services và Nvidia đều đang gấp rút đưa các sản phẩm hàng đầu của mình ra thị trường trong bối cảnh nhu cầu tăng vọt. Cả hai đều dựa vào TSMC (Đài Loan) để sản xuất chip AI cho họ. TSMC là hãng sản xuất chip theo hợp đồng số 1 thế giới.

“Về nguồn cung, chúng tôi đang ở trạng thái khá tốt trên toàn bộ chuỗi cung ứng. Khi chúng tôi sản xuất các hệ thống, thành phần duy nhất mà chúng tôi không thể lấy nguồn cung từ hai nhà cung cấp khác nhau là các chip Trainium”, Gadi Hutt nói với Reuters.

Hồi tháng 11.2024, Amazon thông báo nâng tổng số tiền đầu tư vào Anthropic (đối thủ cạnh tranh với OpenAI) lên 8 tỉ USD. Mục tiêu khi Amazon chi số tiền này là mong chip AI của mình được sử dụng nhiều hơn để đào tạo và vận hành các mô hình ngôn ngữ lớn.

Để đổi lấy khoản tiền đầu tư đó, Anthropic cho biết sẽ sử dụng Amazon Web Services làm "đối tác chính về đào tạo AI và đám mây".

Ngoài ra, Anthropic cũng tuyên bố sẽ giúp Amazon thiết kế chip Trainium trong tương lai và đóng góp vào việc xây dựng Neuron - nền tảng phát triển mô hình AI của Amazon.

Đây được xem là đòn tấn công trực diện vào Nvidia, công ty thống trị thị trường chip AI với GPU, máy chủ và nền tảng CUDA.

CUDA (Compute Unified Device Architecture) là nền tảng tính toán song song và mô hình lập trình được phát triển bởi Nvidia. Nó cho phép các nhà phát triển tận dụng sức mạnh của GPU của Nvidia để thực hiện các tác vụ tính toán chung, vượt ra ngoài mục đích hiển thị đồ họa truyền thống.

Thách thức với Amazon là thuyết phục Anthropic thực sự sử dụng chip Trainium trên quy mô lớn. Chuyển đổi từ GPU Nvidia là phức tạp, tốn thời gian và rủi ro với các nhà phát triển mô hình AI. Amazon từng gặp khó khăn với điều đó.

Amazon Web Services là nền tảng điện toán đám mây toàn diện và được sử dụng rộng rãi nhất trên thế giới, do tập đoàn Amazon cung cấp.

Amazon Web Services cung cấp các dịch vụ điện toán, lưu trữ, cơ sở dữ liệu, mạng, phân tích, AI và học máy… thông qua đám mây, cho phép các cá nhân, công ty và chính phủ thuê và sử dụng các tài nguyên công nghệ theo nhu cầu và trả phí theo mức độ sử dụng.

Một số điểm nổi bật của Amazon Web Services

Đa dạng dịch vụ: Cung cấp hàng trăm dịch vụ khác nhau, từ các máy chủ ảo (EC2), lưu trữ đối tượng (S3) đến các dịch vụ AI/học máy tiên tiến như Amazon SageMaker, hay các dịch vụ cơ sở dữ liệu chuyên biệt.

Linh hoạt và khả năng mở rộng: Người dùng có thể dễ dàng tăng hoặc giảm tài nguyên theo nhu cầu, giúp tối ưu hóa chi phí và hiệu suất.

Bảo mật: Được thiết kế với mức độ bảo mật cao, đáp ứng các yêu cầu khắt khe của nhiều ngành nghề, gồm cả tài chính và chính phủ.

Cộng đồng lớn: Có một cộng đồng khách hàng và đối tác toàn cầu rộng lớn, hỗ trợ và thúc đẩy sự đổi mới liên tục.

Đổi mới liên tục: Amazon liên tục đầu tư và phát triển các công nghệ mới, cập nhật những tính năng và cải tiến dịch vụ hàng tuần dựa trên phản hồi của khách hàng.

Nhờ những ưu điểm này, Amazon Web Services đã trở thành lựa chọn hàng đầu cho hàng triệu khách hàng, từ các công ty khởi nghiệp phát triển nhanh chóng đến một số tập đoàn lớn nhất trên thế giới, giúp họ linh hoạt hơn, giảm chi phí và đổi mới nhanh chóng.